Sabe aquela sensação que o torcedor tem que quando determinado jogador está em campo, o time vai bem? Podemos traduzir isso através dos números, analisando o aproveitamento de cada jogador no campeonato (considerando apenas os pontos da partida para o jogador quando ele esteve em campo). E se fizéssemos isso para todos os jogadores do Campeonato Brasileiro 2016 e montássemos a seleção dos jogadores com melhores aproveitamentos?

No Brasileirão 2016, ninguém foi melhor nesta estatística que o goleiro Jaílson, do Palmeiras. Ele terminou o campeonato invicto (14V – 5E – 0D), o que dá um aproveitamento de 82,5%. Evidentemente a maioria dos jogadores da seleção é do Palmeiras, que foi o campeão com boa vantagem. Dos outros clubes, destaque para Ricardo Oliveira (Santos) e Diego (Flamengo), que tiveram aproveitamentos superiores a 70% quando estiveram em campo (para se ter uma ideia, o Palmeiras foi campeão com 76,9% de aproveitamento). Se eles tivessem disputado todos os jogos…

Importante: para entrar na seleção, o jogador precisou disputar pelo menos 40% dos minutos do campeonato (ou seja, 1368 minutos). Acredito que definir o mínimo de minutos ao invés de jogos é mais justo, pois muitos jogadores têm muitos jogos mas sempre entrando no final, participando pouco.

Segue abaixo a seleção dos melhores aproveitamentos (titulares e reservas):

TOP 3 de cada clube

Quer saber quem foram os jogadores de melhor aproveitamento do seu clube? Segue abaixo o TOP 3:

Palmeiras: 1- Jaílson (82,5%), 2- Gabriel Jesus (72,8%), 3- Jean (72,4%)

Santos: 1- Ricardo Oliveira (73,3%), 2- Thiago Maia (65,6%), 3- Luiz Felipe (65,4%)

Flamengo: 1- Diego (70,6%), 2- Pará (69,1%), 3- Rafael Vaz (64,4%)

Atlético-MG: 1- Erazo (63,3%), 2- Leonardo Silva (61,3%), 3- Robinho (58,9%)

Botafogo: 1- Carli (62,5%), 2- Airton (61,9%), 3- Rodrigo Lindoso (60,0%)

Atlético-PR: 1- Léo (58,9%), 2- Thiago Heleno (54,5%), 3- André Lima (54,3%)

Corinthians: 1- Uendel (53,5%), 2- Guilherme (53,3%), 3- Giovanni Augusto (50,0%)

Ponte Preta: 1- Jeferson (56,7%), 2- Douglas Grolli (53,6%), 3- João Vitor (49,0%)

Grêmio: 1- Everton (56,8%), 2- Douglas (52,9%), 3- Maicon (50,8%)

São Paulo: 1- João Schmidt (53,0%), 2- Buffarini (52,1%), 3- Rodrigo Caio (50,0%)

Chapecoense: 1- Kempes (50,7%), 2- Josimar (50,6%), 3- Lucas Gomes (50,0%) #ForçaChape

Cruzeiro: 1- Rafael (54,9%), 2- Lucas Romero (51,4%), 3- Manoel (50,0%)

Fluminense: 1- Diego Cavalieri (51,4%), 2- Wellington (48,3%), 3- William Matheus (48,3%)

Sport: 1- Ronaldo Alves (53,3%), 2- Rogério (46,2%), 3- Magrão (46,1%)

Coritiba: 1- Raphael Veiga (52,6%), 2- Edinho (50,0%), 3- Luccas Claro (44,9%)

Vitória: 1- Amaral (49,2%), 2- Euller (44,4%), 3- Marcelo (43,9%)

Internacional: 1- Danilo Fernandes (49,4%), 2- Vitinho (44,0%), 3- Fabinho (42,7%)

Figueirense: 1- Marquinhos (44,4%), 2- Elicarlos (40,4%), 3- Rafael Moura (37,9%)

Santa Cruz: 1- Neris (39,7%), 2- Tiago Costa (37,3%), 3- Tiago Cardoso (30,4%)

América-MG: 1- Ernandes (31,9%), 2- Jonas (29,6%), 3- Juninho (27,5%)

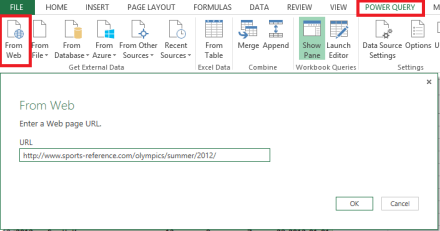

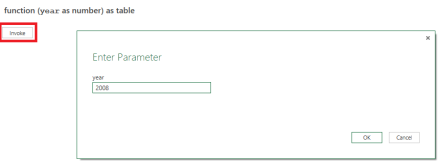

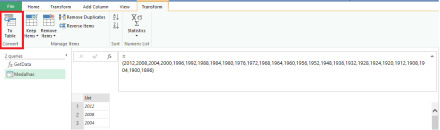

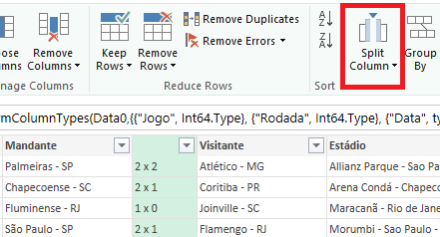

Para consolidar estes dados foi aplicada uma técnica que é muito utilizada pelos cientistas de dados chamada de web scraping, que consiste basicamente em capturar dados da web. Foi escolhido o site do Fox Sports para buscar os dados de todas as escalações de todos os 379 jogos do campeonato.

Referências:

Lineup Builder – Site para montar esquemas táticos

Fox Sports – Campeonato Brasileiro 2016

Sugestão de leitura relacionada:

Estatísticas destacam os melhores jogadores na luta pelo título brasileiro